近日,我中心苏劲松老师课题组的最新研究成果 "A Simple yet Effective Self-Debiasing Framework for Transformer Models"被Artificial Intelligence(CCF-A类期刊)录用。论文第一作者是我中心21级博士生王笑月,通讯作者是苏劲松教授,由刘鑫(密歇根大学),王丽杰(百度研究员),吴苏航,和吴华(百度技术委员会主席)合作完成。这也是苏劲松老师课题组在该期刊上发表的第5篇论文。

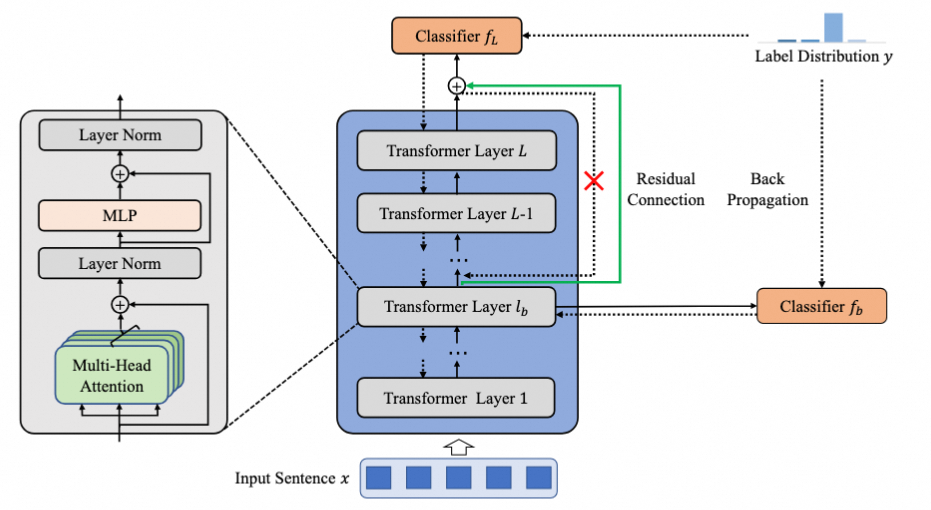

本论文关注于当前基于Transformer的自然语言理解(NLU)模型在应对现实世界的分布外(OOD)实例时,过度依赖数据集偏差的现象。目前大多数方法忽略了Transformer模型不同层所学习的特征存在差异。为此,论文首先通过先导实验得出了两个结论:1)低层和高层的句子表示在训练过程中都编码了常见的偏见特征;2)低层句子表示编码的无偏特征少于高层句子表示。基于上述结论,论文提出了一种适用于Transformer-based NLU模型的简单但有效的自我去偏框架。首先在选定的低层上加入一个分类器,然后引入一个残差连接,将低层句子表示传递给高层分类器。通过这种方式,高层句子表示将能够忽略低层句子表示中的偏见特征,专注于与任务相关的无偏特征。最后在推理过程中移除残差连接,直接使用高层句子表示进行预测。实验证明该框架在小模型和参数量达到1.5B的大模型上均有效,显著缓解了自然语言理解任务中的偏置问题。