近日,我中心姚俊峰教授课题组5篇论文被权威期刊Graphical Models和权威会议ECAI、MICCAI、ICANN、PRCV录用。ECAI会议全称为European Conference on Artificial Intelligence,是人工智能相关领域的权威会议。MICCAI会议全称为International Conference on Medical Image Computing and Computer Assisted Intervention,是医学影像计算与计算机辅助介入领域的顶级会议。ICANN会议全称为International Conference on Artificial Neural Networks,是以人工智能和机器学习、生物启发计算和应用为主题的会议。PRCV会议全称为Pattern Recognition and Computer Vision,是国内顶级的模式识别和计算机视觉领域学术盛会。其中,ECAI、MICCAI会议和Graphical Models期刊在CCF学术推荐列表中被认定为B类,ICANN和PRCV会议被认定为C类。

上述工作得到了国家自然科学基金(62072388)、厦门市公共技术服务平台(No.3502Z20231043)、福建省阳光慈善基金会的资助。被录用论文的相关信息如下:

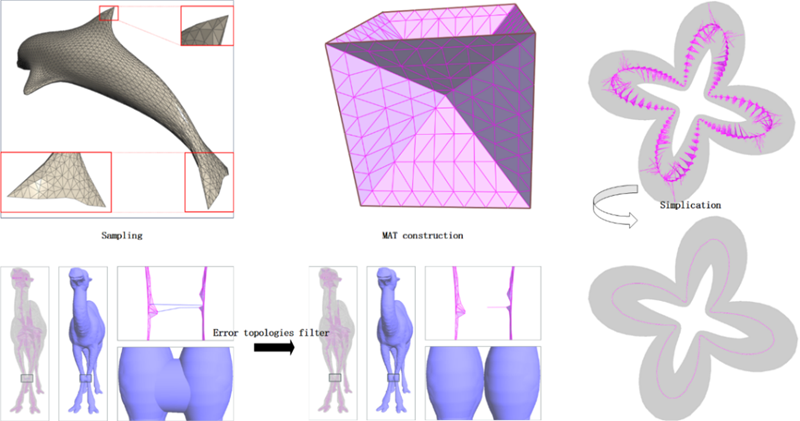

1. 题目:A Detail-Preserving Method for Medial Mesh Computation in Triangular Meshes(作者:Bingchuan Li, Yuping Ye, Junfeng Yao, Yong Yang, Weixing Xie and Mengyuan Ge;收录情况:Graphical Models期刊)。本工作由我中心2021级博士生李冰川、姚俊峰教授、中科院深圳先进院叶于平博士后合作完成。

物体的中轴变换(MAT)是物体内部所有到物体边界上多个最近点的集合。使用MAT表示三角网格的尖锐边缘和角落是一个复杂的挑战。尽管一些研究人员提出使用零半径中轴球体来描绘这些特征,但他们并未明确说明如何在它们之间建立适当的连接。在本文中,我们提出了一种新的框架,用于计算三角网格的MAT,同时保留其特征。初始获得的中轴网格可能包含错误的边缘。此外,在简化过程中,确保中轴球体始终保持在三角网格的范围内是至关重要的。我们的算法在整个简化过程中都能很好地保留关键特征,始终确保球体保持在三角网格内。对各种类型的3D模型的实验表明,我们的算法在稳健性、形状保真度和表示效率方面表现出色。

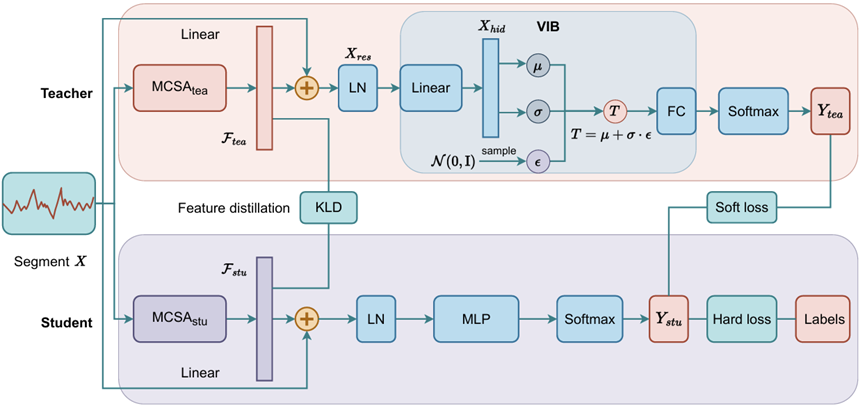

2.题目:Lightweight Transformer for sEMG Gesture Recognition with Feature Distilled Variational Information Bottleneck(作者:Zefeng Wang, Bingbing Hu, Junfeng Yao, Jinsong Su;收录情况:ECAI-2024主会长文)。该项工作由我中心2020级博士生汪泽丰、2023级博士生胡兵兵、姚俊峰教授、苏劲松教授合作完成。

随着深度学习的快速发展,基于表面肌电图(sEMG)的手势识别在各种任务和指标上的性能都有了显著提高。然而,目前用于 sEMG 识别的深度神经网络仍然存在挑战。例如,卷积神经网络对全局特征的捕捉能力较差,递归神经网络的并行处理能力有限,其混合网络通常更为复杂。此外,最近基于Transformer的网络很少考虑注意力的局部性和抗噪性。为了充分发掘 sEMG 序列的本质,并在确保特征学习性能的同时使模型更加轻量、稳健,我们在本文中提出了特征蒸馏变分信息瓶颈(FDVIB)。该方法利用知识蒸馏技术,在特征和预测层面上从高精度教师模型中学习,大大减少了参数和计算量,简化了结构。它还利用 VIB 增强了模型的鲁棒性。我们利用所提出的方法构建了一个Transformer模型,并进行了一系列评估。实验结果表明,我们的分类准确性与最先进的方法相比具有竞争力,同时也证明了我们的方法在增强模型轻量化和鲁棒性方面的有效性。

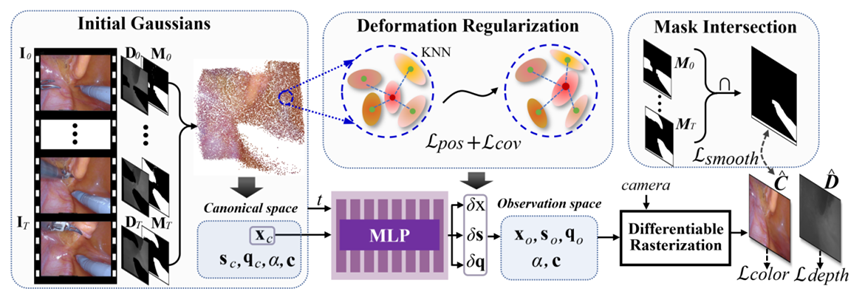

3.题目:SurgicalGaussian: Deformable 3D Gaussians for High-Fidelity Surgical Scene Reconstruction(作者:Weixing Xie, Junfeng Yao, Xianpeng Cao, Qiqin Lin, Zerui Tang, Xiao Dong, Xiaohu Guo;收录情况:MICCAI-2024主会长文)。本文由我中心2021级博士生谢卫星、姚俊峰教授、北师港浸大董潇助理教授和德克萨斯大学达拉斯分校郭小虎教授合作完成。

内窥镜视频中可变形组织的动态重建是机器人辅助手术的关键技术。最近基于神经辐射场(NeRF)的重建方法在手术场景重建中取得了显著的效果。然而,基于隐式表示的 NeRF 难以捕捉场景中物体的复杂细节,无法实现实时渲染。此外,受限的单视图感知和遮挡的器械也对手术场景重建提出了特殊的挑战。为了解决这些问题,我们开发了 SurgicalGaussian,一种可变形的 3D 高斯 Splatting 方法,用于建模动态手术场景。我们的方法通过前向映射变形 MLP 和正则化来建模每个时间戳的软组织时空特征,以约束局部 3D 高斯符合一致的运动。通过深度初始化策略和工具掩码引导训练,我们的方法可以移除手术器械并重建高保真手术场景。通过对各种手术视频的实验,我们的网络在渲染质量、渲染速度和 GPU 使用率等许多方面都优于现有方法。项目页面位于https://surgicalgaussian.github.io。

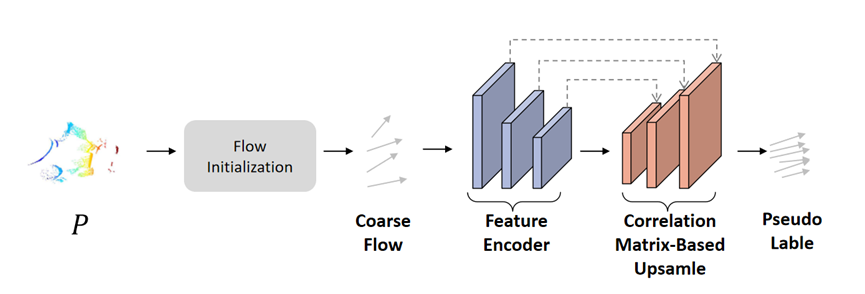

4. 题目:SSFlowNet: Semi-supervised Scene Flow Estimation On Point Clouds With Pseudo Label(作者:Jingze Chen, Qiqin Lin, and Junfeng Yao;收录情况:ICANN-2024主会长文)。本文由我中心2022级硕士生陈璟泽、林祺钦、姚俊峰教授合作完成。

本文介绍的 SSFlowNet 是一种用于场景流预测的半监督方法,它优化了标记成本与模型训练精度之间的平衡。SSFlowNet 创新性地使用伪标签的训练方式,减少了对大量标签数据集的依赖,同时保持了较高的模型精度。神经网络模型关注点云的局部和全局几何结构,并结合空间记忆特征模块,从而学习连续时间框架内各点之间的几何关系。通过计算已标注点和未标注点之间的相似性,SSFlowNet 动态构建相关矩阵,以评估点级场景流间的依赖关系。实证结果表明,SSFlowNet 在伪标签生成方面超越了现有方法,并显示出对不同数据量的适应性。

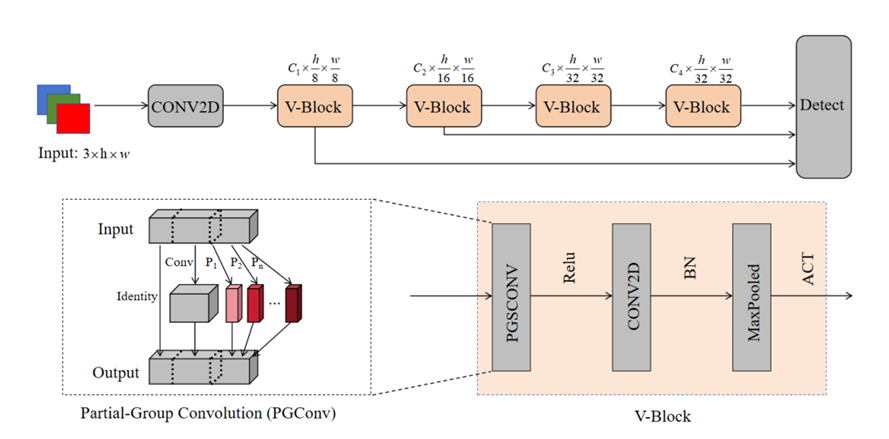

5. 题目:PGNET: A Real-time efficient model for underwater object detection(作者:Yixian Liu, Shibo Cong, Junfeng Yao;收录情况:PRCV-2024主会)。该项工作由我中心2022级硕士生刘逸先、2021级硕士生从士博、姚俊峰教授合作完成。

在水下物体检测领域,由于水下勘探设备通常资源紧张,使用的目标检测模型的实时性和轻量是关键要求。为了满足这些特定需求,我们提出了PGNet,一种创新且轻量级的主干架构,有效降低了模型的计算需求和推理时间,同时确保高水平的准确性。我们在两个不同的水下图像数据集上进行了实验。在淡水-海水混合数据集上,我们的设计超越了现有的轻量级主干模型,参数数量仅为2.01M,计算消耗仅为4.5 GFLOPs。在验证集上评估时,我们的模型达到了0.968的平均精度,并且能够达到318 FPS的高帧率。这些结果无疑展示了我们提出的方法在水下物体检测领域的卓越性能和高效性。PGNet在海洋科学、水下工程和水下救援等实际应用中具有重要潜力。