近日,计算机图形学与多媒体国际会议ICASSP 2024公布录用结果,我中心2篇论文被录用。ICASSP会议全称为International Conference on Acoustics, Speech and Signal Processing,在CCF学术推荐列表中被认定为B类会议。

此次被录用的论文的相关信息如下:

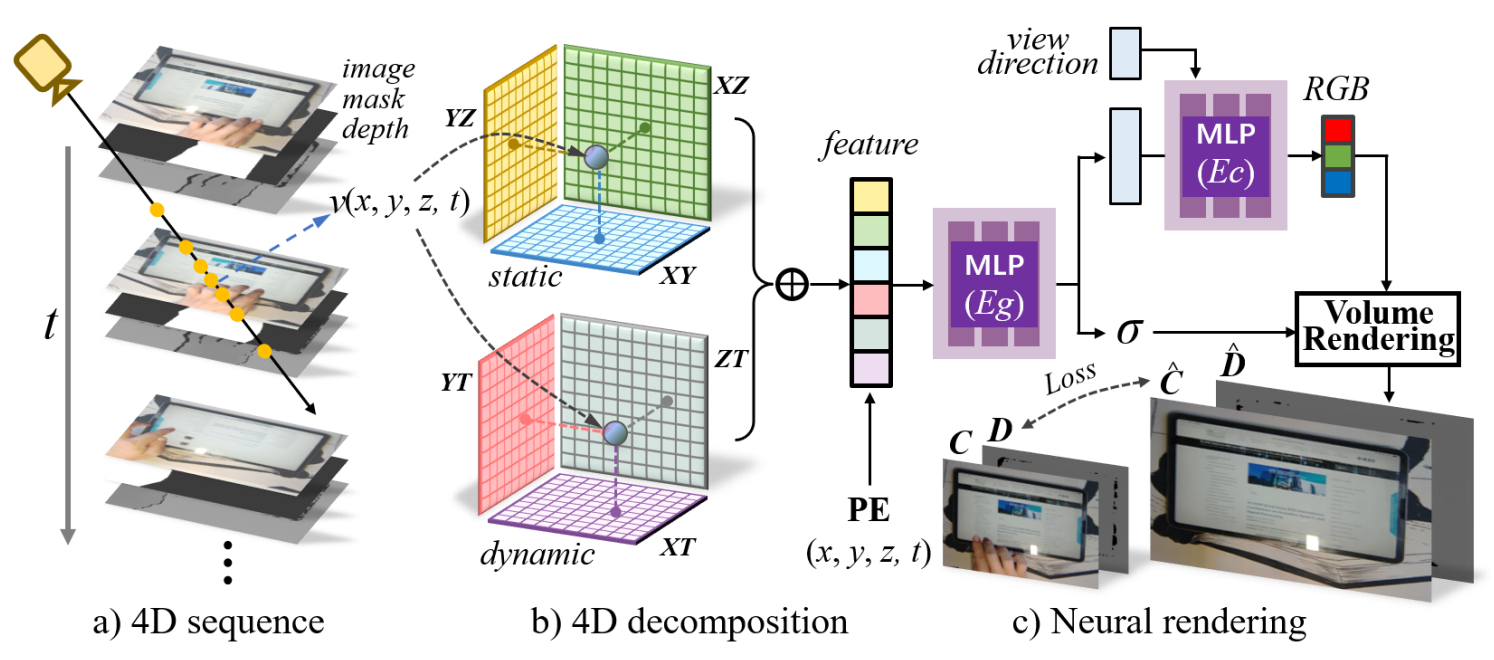

题目:DRSM: Efficient Neural 4D Decomposition for Dynamic Reconstruction in Stationary Monocular Cameras(作者:Weixing Xie, Xiao Dong, Yong Yang, Qiqin Lin, Jingze Chen, Junfeng Yao, Xiaohu Guo)。本文由我中心2021级博士生谢卫星,姚俊峰教授,北师港浸大董潇老师和德克萨斯大学达拉斯分校郭小虎教授合作完成。

本工作研究固定单目相机的动态场景快速重建问题,与利用多视图观测构建场景表示相比,从固定单视角快速建模动态场景拥有更多限制。受神经渲染最新进展的启发,本工作提出了一种新的框架来解决单目相机中动态场景的4D分解问题。该框架利用分解的静态和动态特征平面来高效表示4D场景,并强调通过密集光线投射来学习动态区域。此外,来自单个视图的3D线索不足和遮挡也是场景重建中的特殊挑战。为了克服这些困难,本工作提出了深度监督优化和光线投射策略。本工作在拍摄的6个单视角场景中验证了所提方法的有效性,与现有的单视图动态场景表示方法相比,重建的场景具有更高的质量,同时重建时间缩短了44倍。

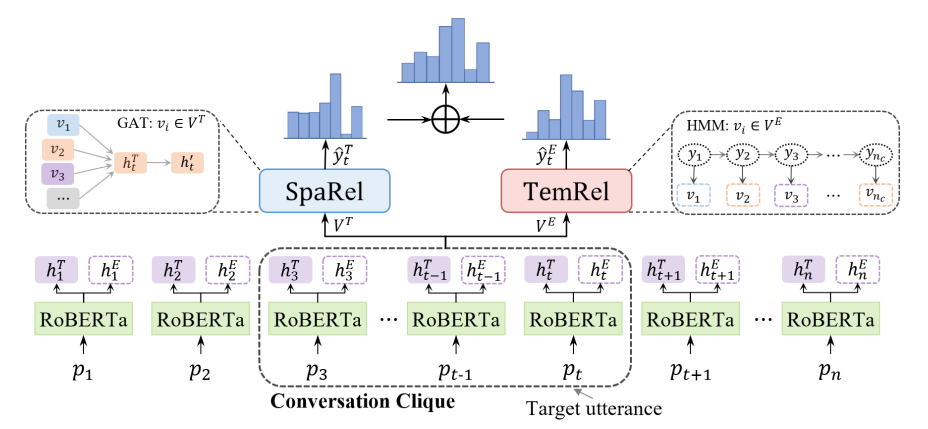

题目:Conversation Clique-Based Model for Emotion Recognition in Conversation(作者:Zhongquan Jian, Jiajian Li, Junfeng Yao, Meihong Wang, Qingqiang Wu)。本文由我中心2021级博士生简忠权,2022级硕士生李嘉键,姚俊峰教授,王美红副教授,吴清强教授合作完成。

本工作聚焦于对话中的情绪识别任务(ERC),该任务难点在于如何提取并整合对话中有效的上下文信息。之前工作证明,考虑历史对话信息对于识别当前话语的情绪类别是有益的,然而,粗暴地考虑整个对话地历史内容将不可避免地引入大量不相关的信息,容易混淆模型从而导致错误的情绪预测。为了缓解这个问题,本文提出一种基于对话团的情绪识别模型CCM。一方面,通过将部分历史对话拼接到当前话语中,扩展了每个话语的内容;另一方面,定义了对话中对话团地概念,设计了对话空间关系模块(SpaRel)和情绪时序约束模块(TemRel)来对对话团中的信息进行建模。本工作在ERC任务上广泛使用的MELD数据集上进行了充分的实验探索,验证了CCM的有效性,并通过消融实验证明了提出的模块在提取对话有效信息的能力。