近日,我中心自然语言处理研究组完成的论文Neural Machine Translation with GRU-Gated Attention Model被IEEE Transactions on Neural Networks and Learning Systems(TNNLS)期刊录用。TNNLS期刊是是人工智能领域,深度学习方向的国际权威期刊,在CCF学术推荐列表中认定为B类刊物,影响因子为11.68。

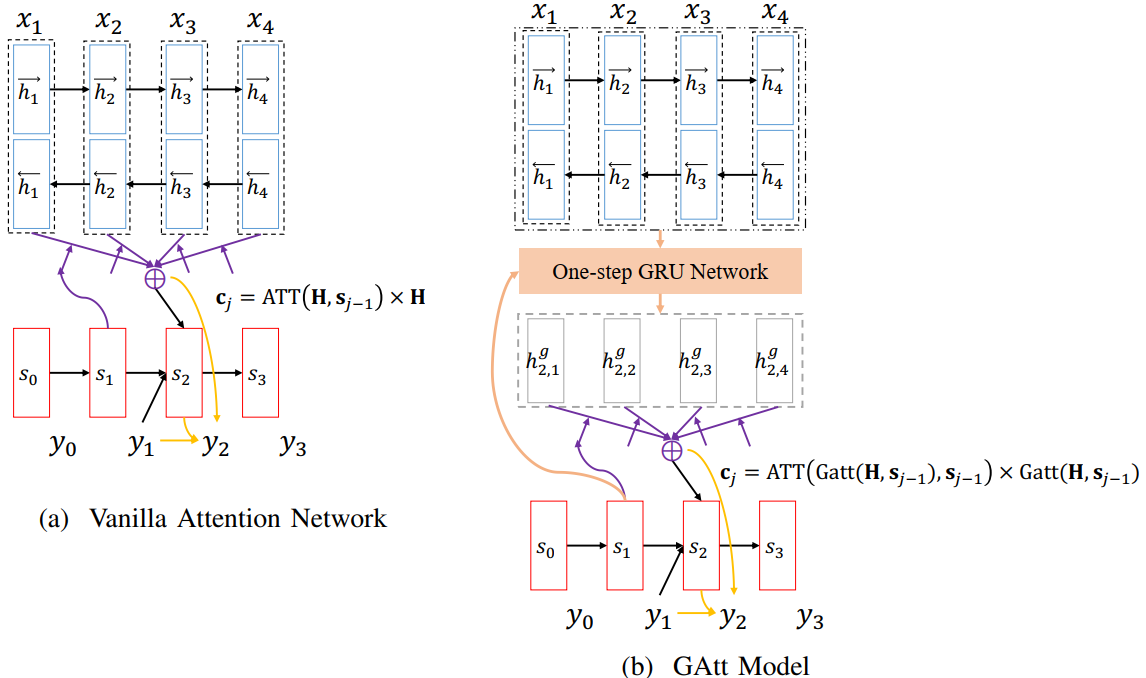

论文由中心2018届硕士研究生张飚,天津大学熊德意教授,腾讯谢军研究员,中心苏劲松副教授合作完成。论文首先分析了现有NMT模型存在的缺陷:现有NMT模型的译文预测高度依赖于注意力机制所生成的上下文向量,而不同目标词的上下文向量非常相似,影响了译文预测的效果。对此,本论文提出一种新颖的GRU门控注意力模型(GAtt)。该模型使用解码器前状态,通过GRU来更新源端表示,从而使得源端表示能够感知翻译过程,产生具有区分度的上下文向量。更进一步,本论文提出了一种GAtt变种模型,该模型通过交换源端表示和解码器的前状态到GRU的输入次序进一步提升了性能表现。中英,英德翻译实验的结果证明了论文所提模型的有效性。

该项目得到了国家自然科学基金(Nos. 61672440, 61622209, 61861130364)、国家重点研发计划(No. 2019QY1802/03)、国家语委科研项目(No. YB135-49)、福建省自然科学基金(No.2016J05161)等的资助。

张飚同学是中心2018届硕士毕业生,现爱丁堡大学全奖攻读博士学位。先后获得2017年国家奖学金,2018年百度奖学金(全球10名,至今唯一硕士获奖的同学),2018年度福建省优秀硕士学位论文。在读期间,张飚同学对统计机器翻译,神经网络机器翻译进行了深入研究,共发表论文20余篇(其中包括CCF-A类4篇,CCF-B类12篇)。